En el pasado te hemos contado sobre estudiantes que han usado inteligencia artificial en sus trabajos escolares. En algunos casos como ayuda para la investigación o para mejorar su redacción, y en otros dejando que la IA se encargue de todo. Pero además del debate sobre si es o no ético el empleo de modelos de lenguaje generativo para esta clase de tareas, existe otra duda: ¿cómo afecta esto al cerebro humano?

Esto es lo que trató de responder un equipo del MIT mediante un experimento que reunió a 54 estudiantes, los cuales tuvieron que realizar tareas de redacción con y sin ayuda de ChatGPT. La conclusión fue que la dependencia excesiva a esta herramienta genera algo a lo que denominaron “deuda cognitiva“, ya que sustituye los procesos necesarios para el pensamiento independiente.

Sobre el experimento

Para estudiar cómo afecta al cerebro el uso de modelos de lenguaje grande (LLM, por sus siglas en inglés) como ChatGPT, los investigadores liderados por Nataliya Kos’myna dividieron a los estudiantes en tres grupos y los sometieron a tres sesiones de redacción de ensayos. El primero podía hacer uso de ChatGPT para completar dichas tareas; el segundo no, pero tenía acceso a motores de búsqueda como Google; finalmente, el tercer grupo debía escribir los textos sin ninguna ayuda más que la de su cerebro.

Al final se realizó una cuarta sesión en la cual los investigadores invirtieron los papeles entre el grupo “de solo cerebro” y el grupo “de ChatGPT“. La indicación era la siguiente: los primeros debían usar el LLM para escribir un último ensayo, mientras que el segundo solo debía utilizar su cerebro para completar la tarea.

La actividad cerebral de los participantes se registró mediante encefalografía (EEG). Con esta herramienta se evaluó tanto su compromiso como su carga cognitivos. Además se entrevistó a cada estudiante después de cada sesión y se calificó los trabajos con ayuda de profesores y con un juez de inteligencia artificial específicamente diseñado para este experimento.

La deuda cognitiva

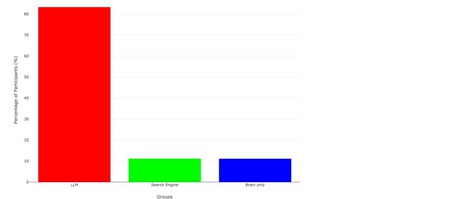

El estudio, que aún no ha sido revisado por pares pero que se encuentra disponible en línea, reveló cosas muy interesantes. En primer lugar, el análisis de EEG presentó “evidencia sólida” de que entre los tres grupos había significativas diferencias de sus patrones de conectividad neuronal. Mientras que el grupo de “solo cerebro” mostró redes neuronales más fuertes y con mayor alcance, el grupo “de ChatGPT” mostró un 55% menos de conectividad neuronal. En el caso del grupo “de motor de búsqueda“, este se encontraba en un punto intermedio (entre 34% y 48% de conectividad neuronal).

Durante la cuarta sesión, el grupo “LLM a cerebro” mostró una conectividad neuronal más débil y una menor capacidad para recordar que el grupo “Cerebro a LLM“. Además, durante las entrevistas, más del 83% de quienes usaron IA no pudo citar fragmentos de los ensayos que acaban de escribir. Esto se debía a que no generaban un compromiso crítico con el tema, “porque ChatGPT ha hecho el trabajo de pensar“.

Al respecto, los investigadores advierten que la dependencia excesiva hacia los sistemas externos como los LLM puede dar pie a la acumulación de “deuda cognitiva“, que a largo plazo genera menor capacidad crítica, mayor vulnerabilidad a la manipulación y reducción de la creatividad. “Cuando los participantes reproducen sugerencias sin evaluar su precisión o relevancia, no solo pierden la propiedad de las ideas, sino que también corren el riesgo de internalizar perspectivas superficiales o sesgadas“.

¿Es malo usar ChatGPT?

Los investigadores concluyen que el uso excesivo de la IA en proyectos académicos podría perjudicar el aprendizaje, especialmente, de alumnos jóvenes. Asimismo, señalan la “urgencia” de explorar más a fondo los cambios en las habilidades de aprendizaje y el impacto cognitivo y práctico del uso de la IA en entornos educativos.

¿Es entonces la IA perjudicial? Al respecto, un estudio de 2024 concluyó que no. De hecho, afirman los autores, puede beneficiar a estudiantes con dificultades para desarrollar habilidades cruciales para el aprendizaje. Sin embargo, advirtieron que el uso de la IA en el ámbito académico debe ser moderado y, en el caso de estudiantes más jóvenes, guiado por profesores. Además, consideran crucial la enseñanza sobre las consideraciones éticas de emplear LLM.

Cortesía de Xataka

Dejanos un comentario: