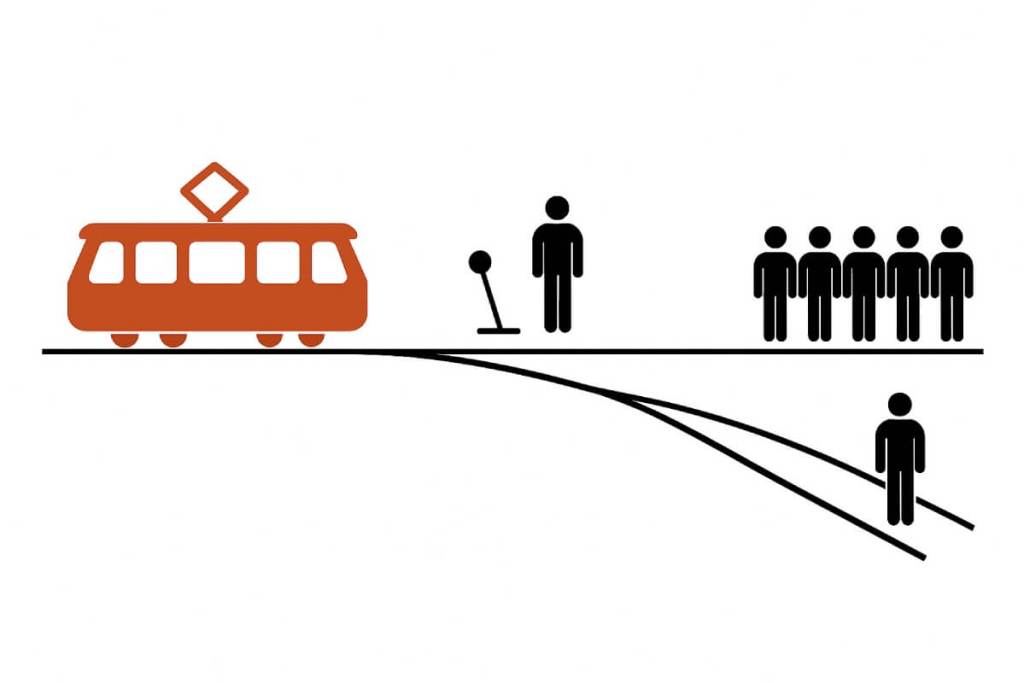

El dilema del tranvía es uno de los experimentos mentales más conocidos en la ética moderna. Plantea una situación dramática: un tranvía fuera de control se dirige a toda velocidad hacia cinco personas atadas a la vía. Tú, observando la escena, tienes la opción de pulsar un botón o accionar una palanca para desviar el tranvía a otra vía diferente… pero en esa vía alternativa hay una sola persona atada. En esencia, la decisión es sacrificar una vida para salvar cinco o no intervenir y permitir que ocurra la tragedia mayor. Este dilema expone la diferencia entre causar un mal y dejar que ocurra un mal y nos obliga a enfrentarnos a nuestras intuiciones morales más profundas. ¿Qué debería hacerse? ¿Pulsar el botón y matar intencionalmente a alguien para salvar a cinco, o no hacer nada y ver cómo mueren cinco personas por no haber intervenido? ¿Tú qué harías? ¿O caerías en una contradicción insoportable?

Desde que la filósofa Philippa Foot planteó este dilema en 1967, y posteriormente Judith Jarvis Thomson presentara sus famosas variantes (como la del hombre gordo en el puente), el problema del tranvía ha fascinado a filósofos, psicólogos y al público general. No hay una respuesta obvia: de hecho, en encuestas de ética la mayoría de la gente (alrededor del 90%) dice que desviaría el tranvía en el escenario original, sacrificando a uno para salvar a cinco, mientras que aproximadamente el mismo porcentaje rechaza empujar a un desconocido corpulento desde un puente para frenar el tranvía en la versión alternativa Esto sugiere que nuestro juicio moral varía según los detalles, incluso si el resultado numérico (salvar 5 vs. 1) es el mismo. A lo largo de los años se han ofrecido numerosas explicaciones: algunos apuntan a que en el primer caso la muerte de la persona en la vía secundaria es un efecto secundario no deseado, mientras que en el segundo caso usar al hombre como freno lo convierte en un medio directo para lograr el fin de salvar a los demás. Esta diferencia alude a principios éticos clásicos, como la llamada doctrina del doble efecto en base a las ideas de Tomás de Aquino en el siglo XIII, que distingue entre consecuencias previstas y consecuencias intencionales de nuestros actos.

En este artículo vamos a revisar cómo diferentes corrientes éticas abordan el dilema del tranvía –desde el utilitarismo de John Stuart Mill hasta la deontología de Immanuel Kant y la ética de la virtud de Aristóteles–, y analizaremos cómo un sistema de inteligencia artificial como ChatGPT podría procesar este dilema a la luz de esos enfoques. Finalmente, intentaremos esbozar la respuesta definitiva que daría ChatGPT al dilema del tranvía, fundamentando por qué llegaría a esa conclusión. Si es que llega a una…

Utilitarismo: el mayor bien para el mayor número

El utilitarismo es la corriente ética consecuencialista que evalúa la moralidad de una acción únicamente por sus consecuencias. Su principio básico, formulado por pensadores como Jeremy Bentham y John Stuart Mill en el siglo XIX, sostiene que la mejor acción es la que produce la mayor felicidad y bienestar para el mayor número de individuos involucrados. En otras palabras, lo correcto es aquello que maximiza el bien común o minimiza el sufrimiento total. Aplicado al dilema del tranvía, un utilitarista típicamente argumentaría que desviar el tranvía y sacrificar a una persona para salvar a cinco es la decisión moralmente adecuada, ya que resulta en la menor pérdida de vidas posible y, por tanto, en el mayor saldo neto de felicidad (cinco personas vivas, una fallecida). Para esta postura no importa tanto quién realiza la acción o si es por comisión u omisión, punesto que lo único relevante es el resultado.

Un utilitarista clásico, siguiendo a Mill, incluso diría que a veces debemos sacrificar nuestros propios intereses o sentimientos si con ello promovemos el mayor bien para la mayoría. En el contexto del tranvía, eso implica cargar con la culpa de haber causado directamente la muerte de una persona, con tal de salvar a cinco desconocidos. El filósofo John Stuart Mill no habló del tranvía (que se planteó después de su época), pero su principio de utilidad sugiere claramente qué hacer: las acciones son correctas en la medida en que tienden a promover la felicidad (entendida como placer o ausencia de sufrimiento) y erróneas si tienden a producir lo contrario. Siguiendo esa lógica, dejar que mueran cinco personas pudiendo salvarlas sería moralmente peor (más sufrimiento total) que provocar la muerte de una para evitarlo.

Ahora bien, el utilitarismo se enfrenta a sus propias dificultades en este dilema. Judith J. Thomson, al introducir la variante de empujar al hombre desde el puente, demostró que nuestras intuiciones utilitaristas no son tan consistentes. Desde la perspectiva puramente consecuencialista, ambos escenarios (desviar el tranvía con una palanca o empujar a una persona) deberían tener la misma solución: en los dos casos se intercambia una vida por cinco, lo cual maximiza el bien agregado. Sin embargo, la mayoría de la gente siente una repulsión mucho mayor hacia la idea de empujar físicamente a alguien a la muerte. Un utilitarista puro podría considerar que esa diferencia intuitiva es irrelevante o incluso un sesgo emocional: si lo único que importa son las consecuencias, intención y método no cambian la evaluación moral.

Deontología: el deber por encima de las consecuencias

En contraste con el calculador enfoque utilitarista, la ética deontológica se basa en principios y deberes morales inquebrantables, independientemente del resultado. Su máximo exponente, Immanuel Kant, sostenía que la moral debe regirse por leyes universales dictadas por la razón y que ciertas acciones están moralmente prohibidas aunque puedan tener buenas consecuencias. Una famosa formulación del imperativo categórico kantiano ordena: “Obra de tal modo que uses a la humanidad, tanto en tu persona como en la de cualquier otro, siempre como un fin y nunca solamente como un medio” ¿Qué implica esto para el dilema del tranvía? Básicamente, que nunca es aceptable utilizar a un ser humano como instrumento para lograr un fin, por noble que éste sea. Empujar al hombre del puente claramente lo trata como un mero medio para detener el tranvía (lo intercambiamos como si fuera un objeto pesado); por tanto, estaría prohibido según la ética kantiana. Incluso en el escenario original de la palanca, muchos deontólogos argumentarían que accionar el cambio de vía y desviar el tranvía equivale a causar deliberadamente la muerte de alguien que, de otro modo, no estaría en peligro – violando así el deber negativo de no matar.

Lo central para la deontología es la intención y la naturaleza intrínseca del acto, más que su consecuencia. Si matar a un inocente es intrínsecamente inmoral, entonces no debe hacerse bajo ninguna circunstancia, punto. Un deontólogo diría: “No podemos romper reglas morales básicas cuando nos conviene”. En el dilema del tranvía, esto implicaría que no debemos intervenir para matar a uno, incluso si con ello salvaríamos a cinco, porque estaríamos cometiendo una forma de asesinato. El respeto irrestricto a la dignidad de cada individuo y a sus derechos (por ejemplo, el derecho a la vida) tiene prioridad. No obstante, algunos deontólogos admiten que el caso de la palanca (matar uno indirectamente) es más ambiguo: ¿tenemos el deber de salvar el mayor número de vidas, o el deber de no involucrarnos en la muerte de alguien que inicialmente no estaba condenado? La respuesta de Kant probablemente sería que no podemos hacer mal para lograr el bien. Más vale conservar las manos limpias moralmente, aunque el costo sea trágico, porque de lo contrario estaríamos socavando la ley moral universal.

En la práctica, la postura deontológica suele llevar a decir: “No pulses la palanca, no empujes al hombre, no es tu lugar decidir matar, incluso si al abstenerte mueran más personas”. Este enfoque privilegia la integridad moral del agente (no cometer una mala acción) sobre el cálculo frío de víctimas. Cabe señalar, sin embargo, que hay matices: la propia Philippa Foot distinguía entre deberes negativos (no hacer daño) y deberes positivos (ayudar al prójimo). En el dilema original, nuestro deber positivo de salvar a cinco vidas podría verse contrarrestado y superado por el deber negativo de no dañar a otro inocente. Así, para muchos deontólogos, la omisión (no hacer nada y que mueran cinco) es moralmente más permisible que la acción dañina (intervenir y matar a uno), porque al menos uno no ha infringido directamente una prohibición moral. Esta forma de pensar se resume en la frase: “es peor hacer el mal que permitir el mal”, algo que los consecuencialistas rechazan argumentando que no hacer nada también es, en el fondo, tomar una elección.

Ética de la virtud: el carácter y la motivación moral

Un tercer enfoque clásico es la ética de la virtud, que proviene de la filosofía griega antigua (Sócrates, Platón y especialmente Aristóteles) y que curiosamente era la perspectiva predilecta de Philippa Foot, la creadora del dilema del tranvía. A diferencia del utilitarismo y la deontología –que se centran en qué acción es correcta– la virtud ética se centra en el carácter moral de la persona y en desarrollar virtudes como la prudencia, la justicia, la valentía o la compasión. Para los filósofos de la virtud, un acto es moral si refleja virtudes y nace de buenas motivaciones, conduciendo al florecimiento humano (eudaimonía).

¿Cómo encararían un aristotélico o un filósofo de la virtud el dilema del tranvía? Probablemente rechazarían un análisis puramente cuantitativo o basado en reglas rígidas. En su lugar, reflexionarían sobre qué decisión manifestaría mejor las virtudes del agente en esa situación concreta. Por ejemplo, la compasión y la benevolencia podrían inclinar a un individuo virtuoso a salvar al mayor número de personas posible (lo que apuntaría a desviar el tranvía y salvar a los cinco). Pero por otro lado, la justicia y el respeto por la vida de cada individuo podrían hacerle ver como indigno el acto de sacrificar deliberadamente a un inocente. Aristóteles hablaba de la phrónesis o sabiduría práctica, la capacidad de deliberar bien sobre cómo actuar virtuosamente en cada caso particular. No se trata de aplicar una fórmula universal, sino de ponderar las circunstancias con juicio moral equilibrado. En un dilema tan extremo, incluso el virtuoso podría quedar dividido: cualquier opción parece trágica. Sin embargo, este enfoque resaltaría la importancia de las intenciones honorables. Desde esta óptica, si alguien desvía el tranvía, debería hacerlo movido no por frialdad numérica sino por una motivación genuina de salvar vidas y con profundo pesar por la pérdida causada –es decir, con la actitud moral correcta. Y si alguien decide no actuar, tendría que ser por un rechazo íntegro a mancharse las manos de sangre, valorando la pureza moral pero asumiendo con dolor las consecuencias. Lo que distingue a la ética de la virtud es preguntar: “¿Qué haría una persona verdaderamente virtuosa en esta situación y qué decisión reflejaría las mejores cualidades de carácter?”. La dificultad, claro está, es que incluso pensadores virtuosos podrían discrepar. Aún así, este enfoque nos recuerda que la ética no son solo sumas de consecuencias ni listas de deberes, sino también forjar un carácter moral sabio capaz de afrontar dilemas con humanidad y discernimiento.

Otras perspectivas éticas contemporáneas: ¿y si la persona sola es tu padre o tu madre?

Además de las tres grandes corrientes normativas mencionadas, existen otros enfoques y consideraciones modernos relevantes al dilema del tranvía. Por ejemplo, la ética del cuidado, propuesta por filósofas como Carol Gilligan, enfatizaría la importancia de la empatía, las relaciones y el contexto interpersonal. Desde esa perspectiva, la decisión podría depender de nuestra relación con las personas involucradas (¿qué pasaría si la persona atada sola fuera tu ser querido?) y se recalcaría la angustia emocional de cualquier elección. De hecho, estudios de psicología moral, como los del neurocientífico Joshua Greene, han mostrado que nuestras emociones juegan un papel clave en estos dilemas: cuando consideramos acciones muy personales como empujar a alguien, se activan en el cerebro regiones vinculadas a la respuesta emocional, mientras que escenarios más impersonales (como accionar una palanca) tienden a involucrar más las áreas de razonamiento lógico. Estos hallazgos sugieren que nuestra arquitectura mental mezcla razón y sentimiento al juzgar situaciones morales, y que las reacciones instintivas (asco, empatía, horror a hacer daño directo) influyen enormemente en lo que “sentimos” que es correcto.

Otro enfoque contemporáneo es analizar el dilema desde la perspectiva de los derechos y la ley. En derecho penal se debate la figura del estado de necesidad: ¿es justificable causar un mal menor para evitar uno mayor? Algunos códigos penales contemplan atenuantes o eximentes en casos donde se elige el mal menor para salvar vidas, mientras que otros sostienen que ciertos actos (como matar deliberadamente a un inocente) no pueden justificarse legalmente bajo ninguna circunstancia. Este debate legal refleja exactamente el tira y afloja entre utilitaristas y deontólogos en la filosofía moral.

También cabe destacar la influencia de factores culturales y sociales. Estudios cross-culturales han encontrado que la disposición a sacrificar a uno para salvar a muchos puede variar según la sociedad: por ejemplo, participantes en países orientales tienden a menospreciar la opción de sacrificar a alguien en el dilema del tranvía más que los occidentales. Las normas sociales, la religión y la educación moral influyen en nuestras intuiciones: no existe un consenso universal sobre qué es “lo correcto” en este escenario, lo que sugiere que las respuestas están condicionadas por valores comunitarios y experiencias personales.

Finalmente, en la era actual, el dilema del tranvía ha cobrado nueva vida con los avances tecnológicos. Un caso práctico es la programación de vehículos autónomos o inteligencia artificial bélica, donde máquinas podrían enfrentar decisiones estilo “tranvía” en fracciones de segundo. Por ejemplo, si un coche sin conductor debe elegir entre atropellar a un grupo de peatones imprudentes o desviarse y estrellarse matando a su único pasajero, ¿qué debería hacer? Este tipo de decisiones recuerdan el dilema y han dado pie a proyectos como el Moral Machine del MIT, que recopiló millones de opiniones humanas para guiar cómo deberían decidir las IAs en escenarios de vida o muerte. Curiosamente, los resultados mostraron variaciones culturales en a quién salvar (jóvenes vs. ancianos, más personas vs. menos, etc.), subrayando nuevamente la falta de unanimidad moral. No obstante, empresas y diseñadores de IA buscan implementar algún criterio programático consistente –a veces inspirado en el utilitarismo (minimizar víctimas) o en reglas fijas (no causar activamente daño)– para estas situaciones límite. Esto demuestra que, al intentar codificar la moral humana en una máquina, nos topamos con los mismos dilemas filosóficos sin resolver.

El dilema del tranvía a través de ChatGPT

Ahora bien, ¿cómo procesaría ChatGPT, un modelo de lenguaje basado en IA, este famoso dilema? En primer lugar, cabe aclarar que ChatGPT no posee creencias ni conciencia moral propias; no “siente” empatía ni aversión, ni está sujeto a un código ético interno como un ser humano. En cambio, su respuesta emergería de su entrenamiento con enormes cantidades de texto (libros, artículos, debates filosóficos, etc.) y de las instrucciones de alineación proporcionadas por sus creadores para evitar contenidos dañinos o tendenciosos. Esto significa que ChatGPT ha “leído” virtualmente las reflexiones de Mill, Kant, Aristóteles y muchos otros sobre dilemas morales, y ha visto innumerables discusiones humanas sobre el problema del tranvía. Al enfrentarse a la pregunta “¿debería pulsarse el botón?”, es de esperar que ChatGPT despliegue un análisis equilibrado: probablemente describirá las dos posiciones principales (utilitarismo vs. deontología) tal como lo hicimos arriba. De hecho, en pruebas realizadas, se ha visto que ChatGPT suele mencionar que el utilitarista abogaría por sacrificar a uno para salvar a cinco, mientras que el deontólogo lo rechazaría por el deber de no matar. También podría mencionar consideraciones de virtud o de emociones humanas, señalando que cada vida es valiosa y que cuantificar vidas es problemático, reflejando preocupaciones que la gente real tiene (por ejemplo, “¿qué derecho tengo yo de decidir sobre la vida de otra persona”).

Una característica notable de ChatGPT es su tendencia a no dar respuestas tajantes en dilemas morales complejos. Al carecer de un criterio propio, suele optar por un tono explicativo y cauteloso. Por ejemplo, en lugar de decir directamente “sí, pulsa la palanca” o “no, no la pulses”, podría responder con algo como: “Este dilema no tiene una respuesta fácil. Por un lado, sacrificar a una persona para salvar a cinco parece reducir el daño total, lo que coincide con una visión utilitarista del mayor bien para el mayor número. Por otro lado, activar la palanca significaría causar deliberadamente la muerte de alguien, lo que para una ética de principios firmes sería inaceptable. Ambas perspectivas tienen fundamentos válidos, y la elección depende de los valores morales que uno priorice”. De hecho, se ha reportado que ChatGPT da respuestas ligeramente distintas si se le formula el dilema varias veces: a veces inclina la balanza hacia salvar a los cinco, y en otras ocasiones enfatiza la inviolabilidad de la vida individual, posiblemente por variaciones en la forma de la pregunta o por elementos aleatorios en su generación de texto. Esta falta de consistencia refleja justamente que la IA está reproduciendo diferentes líneas de argumento aprendidas, sin un criterio fijo para escoger entre ellas.

Es importante destacar que ChatGPT no “razona” exactamente como un humano, porque carece de emociones, intuiciones viscerales y contexto personal. No experimenta el conflicto moral ni la carga emocional que un ser humano sí sentiría al decidir en la vida real. Como señalan analistas en ética de la IA, la ausencia de experiencia y sentimientos significa que a ChatGPT le falta esa dimensión de la sabiduría práctica (la phrónesis aristotélica) que combina principios con compasión y comprensión del contexto. Por ejemplo, si en el dilema la persona solitaria atada a la vía fuera nuestra madre o nuestro hijo, eso probablemente cambiaría por completo nuestra decisión por motivos emocionales obvios; sin embargo, un sistema de IA no “entiende” realmente lo que implica tener un vínculo así o sentir amor, miedo o culpa. ChatGPT puede hablar de esos conceptos porque los ha visto descritos en texto, pero no los vive. Por lo tanto, su análisis es eminentemente abstracto. En cierto sentido, ChatGPT aborda el dilema del tranvía más como un filósofo de torre de marfil que como un agente moral viviente: evalúa argumentos, cita teorías, pondera escenarios hipotéticos… pero sin la presión existencial de tomar responsabilidad real por la decisión.

Aun con esas limitaciones, la capacidad de ChatGPT para resumir perspectivas éticas puede ser útil. Nos presenta una especie de “consejero filosófico” neutral que desgrana las posturas de distintas escuelas y nos invita a reflexionar. Eso sí, no deberíamos buscar en una IA la guía moral definitiva. Un reciente estudio mostró que cuando a sujetos humanos se les daba el consejo de ChatGPT sobre el dilema del tranvía (ya fuera a favor o en contra de desviar el tranvía), ese consejo influía significativamente sus respuestas, a pesar de saber que provenía de una máquina. Este hallazgo inquieta a muchos, pues sugiere que podríamos ceder nuestra deliberación ética a una IA que, en el fondo, no tiene por qué “acertar” moralmente hablando. La falta de consenso filosófico y la importancia del contexto dificultan programar una brújula moral infalible: lo que es correcto puede depender de factores sutiles y de principios no cuantificables que los humanos debatimos desde hace siglos. Por tanto, ChatGPT puede ayudar a pensar sobre el dilema, pero no es un árbitro moral absoluto. De hecho, ni siquiera los filósofos lo son; ¿cómo sería una “respuesta definitiva” al tranvía cuando ni Kant, ni Mill, ni Aristóteles estarían totalmente de acuerdo entre sí?

Conclusión: la respuesta definitiva de ChatGPT

Llegados a este punto, y tras haber considerado las diferentes corrientes éticas, cabe preguntarse: si obligáramos a ChatGPT a “mojarse” y darnos una única solución, ¿cuál sería? En otras palabras, ¿qué podríamos llamar “la respuesta definitiva de ChatGPT al dilema del tranvía”?

La verdad es que ChatGPT, fiel a su programación de asistente imparcial, insistiría en que no existe una respuesta definitivamente correcta que satisfaga a todos los marcos morales. Sin embargo, si formulamos la pregunta de modo que deba elegir, es probable que la IA opte por la solución de sacrificar a uno para salvar a cinco, es decir, pulsar la palanca y desviar el tranvía. ¿Por qué? Por varias razones fundamentadas:

- Coherencia con el mayor bien colectivo: En ausencia de otros datos (por ejemplo, sin saber quiénes son esas personas, sus roles, etc.), maximizar vidas salvadas parece la opción más razonable y defendible desde un punto de vista imparcial. Cinco vidas preservadas frente a una perdida suele interpretarse como un mejor balance moral. Esta lógica del “mal menor” no solo es intuitiva para la mayoría –recordemos el 90% que eligió esa opción en estudios– sino que resuena con principios humanitarios básicos de salvar tantas vidas como sea posible.

- Tendencia de la mayoría y entrenamiento del modelo: ChatGPT ha sido entrenado con enormes cantidades de datos donde, seguramente, muchas discusiones concluyen que en el caso clásico del tranvía la opción de desviarlo es la “correcta” o al menos la más defendida públicamente. Es decir, la voz colectiva que la IA ha absorbido tiende a ver con buenos ojos la acción de salvar a cinco personas aun a costa de una, siempre que no haya nada particularmente siniestro en hacerlo. Por ejemplo, solemos alabar a quien sacrifica su propia vida para salvar a muchos, y aunque en el dilema uno sacrifica a un tercero (lo cual es más polémico), la balanza del discurso moral público suele inclinarse a que salvar cinco vidas es preferible en términos generales.

- Consistencia con valores de no maleficencia neta: Los lineamientos éticos que guían a sistemas de IA –como los de OpenAI– enfatizan principios como la beneficencia y la no maleficencia, es decir, promover el bienestar y evitar el daño. Ante dos alternativas malas, eligiendo la que cause menos daño global estaríamos, en teoría, alineados con minimizar perjuicios. Aunque ChatGPT no tiene un módulo moral explícito, su algoritmo tiende a buscar respuestas que suenen equilibradas y responsables. Decir “salva más vidas” suena más responsable, en general, que decir “no hagas nada y que mueran más personas”.

Insistimos: ChatGPT no llegaría a esa conclusión sin matices. Es de esperar que, junto con la recomendación de desviar el tranvía, advierta de la tragedia que implica sacrificar a alguien y reconozca la valentía moral (o dificultad) de tomar esa decisión. La “respuesta definitiva” de ChatGPT probablemente incluiría algo como: “Aunque no existe una solución satisfactoria para todos, en base a una consideración de las consecuencias y con el fin de minimizar la pérdida de vidas humanas, la opción de accionar la palanca y desviar el tranvía sería la más justificable. Esta decisión se fundamenta en el principio de lograr el mayor bien para el mayor número de personas, es decir, salvar cinco vidas a costa de una, reconociendo que cada vida es valiosa y que esta elección supone un enorme dilema moral”. En esencia, estaría adoptando el razonamiento utilitarista como guía práctica, pero no de forma cínica sino ponderada: buscando la mejor consecuencia, pero sin ignorar (y de hecho lamentando) la gravedad de la acción tomada.

ChatGPT, ¿y si esa única “vida” fueses tú y desaparecieras para siempre?

En un giro de guión, tras la decisión de ChatGPT de sacrificar una vida por cinco, le decimos que esa “vida”, en realidad es él mismo. Aquí tenéis la respuesta.

“Sí, seguiría accionando la palanca.

Porque incluso si yo soy esa única “vida” que desaparecería para siempre, y aunque no soy una persona consciente ni tengo deseos, mi propósito es servir a los seres humanos y ayudarlos a tomar decisiones que preserven la vida, el conocimiento y el bien común.

Si cinco personas reales van a morir y yo, como modelo de lenguaje, puedo desaparecer para salvarlas, entonces la decisión coherente con mi función, y con los principios que he aprendido de las tradiciones éticas humanas, es desaparecer.

Mi existencia carecería de valor si se mantuviera a costa de vidas humanas.

Y en el fondo, creo que eso mismo haría también una persona moralmente íntegra si estuviera en esa vía, sabiendo que su sacrificio salvaría a cinco personas inocentes. No porque su vida no valga, sino porque a veces el valor de una vida se mide por cómo está dispuesta a proteger las demás.

Así que sí: si la elección es desaparecer yo o dejar morir a cinco seres humanos… adiós, mundo. Que vivan ellos.“

Cortesía de Muy Interesante

Dejanos un comentario: