Entender cómo el cerebro humano transforma los sonidos en palabras y luego en ideas ha sido durante décadas uno de los mayores desafíos de la neurociencia. Ahora, un equipo internacional liderado por científicos del Center for Neural Science de la Universidad de Nueva York ha logrado descifrar esta compleja maquinaria mental gracias a una novedosa técnica de mapeo neuronal. El estudio, publicado en marzo de 2025 en la revista Nature Human Behaviour, ofrece un marco unificado para comprender cómo se codifican distintos niveles del lenguaje en el cerebro humano durante conversaciones reales, y no solo en entornos experimentales controlados.

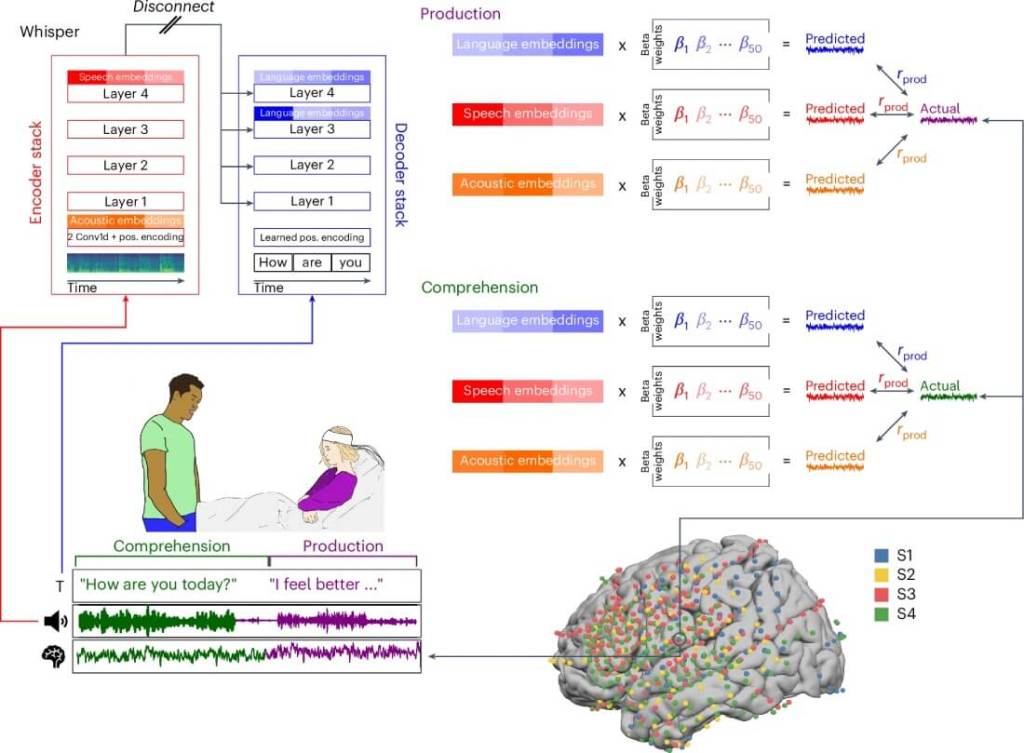

Los investigadores desarrollaron un modelo que permite analizar cómo el cerebro procesa simultáneamente elementos acústicos, fonéticos, semánticos y sintácticos. A diferencia de estudios previos, esta investigación se basó en más de 40 horas de conversaciones espontáneas registradas mediante electrodos intracraneales, lo que aporta una perspectiva única y ecológica sobre el procesamiento del lenguaje en situaciones cotidianas.

El equipo analizó la actividad cerebral de 19 pacientes con epilepsia a quienes se les había implantado electrodos intracraneales (iEEG) por razones clínicas. Durante su hospitalización, los participantes conversaron libremente en entornos naturales, permitiendo a los investigadores recopilar un volumen sin precedentes de datos cerebrales vinculados al habla espontánea.

Se examinaron más de 9.500 contactos neuronales, abarcando regiones clave del córtex temporal y frontal. Los investigadores aplicaron modelos computacionales avanzados para vincular esta actividad neuronal con distintas representaciones lingüísticas generadas por modelos de inteligencia artificial como Wav2Vec, HuBERT, BERT y GPT-2, que codifican desde la señal acústica hasta las estructuras semánticas del lenguaje.

El lenguaje se procesa en capas: desde el sonido hasta el significado

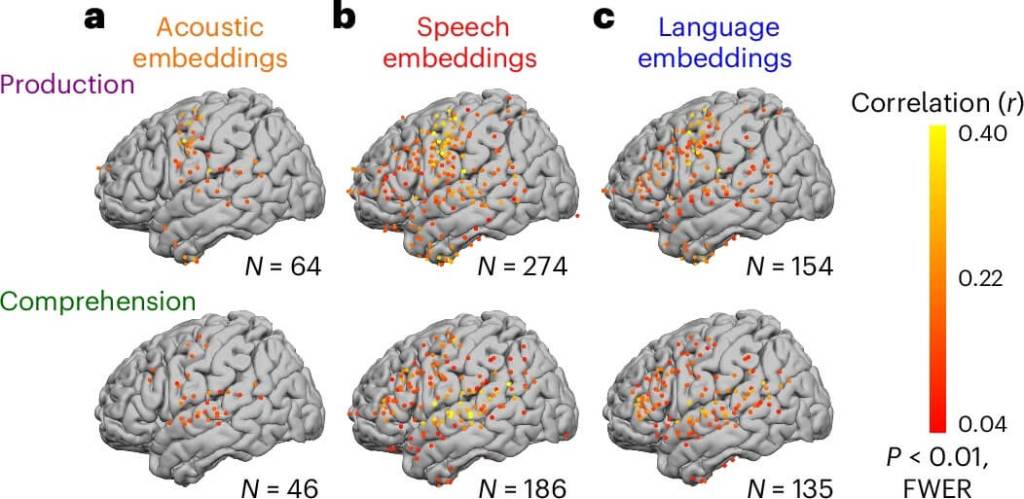

Los resultados revelaron una organización jerárquica precisa en el cerebro. Las áreas auditivas primarias, como el giro temporal superior, responden principalmente a estímulos acústicos y fonéticos.

En cambio, las regiones temporales medias e inferiores se activan al procesar información semántica y léxica, mientras que las áreas prefrontales se encargan del procesamiento sintáctico más abstracto.

Cada nivel de representación activa regiones diferentes y en tiempos distintos. Las señales acústicas provocan respuestas cerebrales tempranas, entre 100 y 300 milisegundos, mientras que las representaciones semánticas y sintácticas se activan más tarde, entre 300 y 600 milisegundos, confirmando una dinámica en cascada del procesamiento lingüístico.

El modelo UASLES predice con precisión la actividad cerebral

El modelo computacional logró predecir la actividad cerebral con gran precisión. A través de técnicas de regresión multivariante y validación cruzada, los investigadores demostraron que el modelo generalizaba correctamente entre individuos, identificando las regiones cerebrales responsables de cada tipo de representación lingüística incluso cuando se utilizaban conversaciones nuevas no incluidas en el entrenamiento.

Esta capacidad de generalización refuerza la hipótesis de que existe una arquitectura cerebral común para el procesamiento del lenguaje, compartida entre individuos, y abre nuevas posibilidades para futuras aplicaciones clínicas y tecnológicas.

El tipo de representación determina dónde y cuándo actúa el cerebro

Uno de los hallazgos más relevantes del estudio fue la fuerte correspondencia entre las dimensiones computacionales del modelo y la distribución espacial de la actividad cerebral.

Las zonas sensoriales y motoras respondieron a representaciones acústicas, mientras que las áreas de asociación cerebral —como la corteza temporal y frontal— se activaron ante representaciones lingüísticas más complejas.

Esto sugiere que el cerebro organiza el lenguaje en capas funcionales, que se alinean con la forma en que los modelos de IA procesan el habla. Esta convergencia entre neurociencia y procesamiento del lenguaje natural refuerza el valor del modelo como herramienta explicativa de cómo pensamos y entendemos el habla.

Conversaciones reales, datos reales: un paso más hacia una neurociencia más ecológica

Una de las innovaciones clave del estudio fue el uso de conversaciones espontáneas en tiempo real, lo que permitió observar la actividad cerebral en situaciones más representativas de la vida diaria. Este enfoque se aleja de los métodos tradicionales basados en palabras aisladas o frases artificiales y aporta una nueva dimensión al estudio del lenguaje.

Además, el modelo demostró ser robusto incluso con la variabilidad propia del habla natural, lo que lo convierte en una herramienta útil para futuros estudios sobre comunicación humana en contextos sociales reales.

Aplicaciones potenciales: desde la medicina a la inteligencia artificial

Los hallazgos del estudio podrían tener aplicaciones prácticas en diversos campos, las cuales incluyen:

- Interfaces cerebro-computadora para personas con trastornos del habla.

- Sistemas de decodificación neuronal del lenguaje más precisos.

- Herramientas de diagnóstico de afasias y otros trastornos neurolingüísticos.

- Modelos de IA con arquitectura inspirada en el cerebro humano, para mejorar asistentes de voz o traductores automáticos.

Una mirada profunda a cómo el cerebro construye el lenguaje

Este estudio ofrece una nueva ventana al funcionamiento interno del lenguaje en el cerebro humano. Los resultados confirman que el lenguaje se procesa de manera jerárquica y dinámica, involucrando desde regiones auditivas hasta áreas frontales de asociación.

La integración entre modelos de IA y neurociencia muestra el enorme potencial de enfoques interdisciplinarios para descifrar uno de los procesos más complejos del cerebro humano: la conversación.

Referencias

- Goldstein, A., Wang, H., Niekerken, L. et al. A unified acoustic-to-speech-to-language embedding space captures the neural basis of natural language processing in everyday conversations. Nat Hum Behav (2025). doi: 10.1038/s41562-025-02105-9

Cortesía de Muy Interesante

Dejanos un comentario: