Las tecnologías cuánticas llevan décadas prometiendo una revolución en computación, criptografía o simulación de materiales. Pero hay un obstáculo silencioso que lleva años frenando ese avance: medir con rapidez sin perder precisión. Es un problema técnico, sí, pero también filosófico. ¿Podemos conocer algo con exactitud si apenas lo observamos? Hasta ahora, la respuesta parecía ser no.

Un nuevo estudio, liderado por investigadores del University of Bristol y publicado en Physical Review Letters, propone un giro inesperado: usar cúbits adicionales para acelerar las mediciones sin que su calidad se vea afectada. Es decir, más velocidad sin coste en fiabilidad. Este enfoque, validado con modelos teóricos y simulaciones realistas, rompe con una de las suposiciones más arraigadas en física cuántica experimental. Y lo hace, además, con una solución elegantemente simple.

Medir rápido, medir bien: un conflicto de base

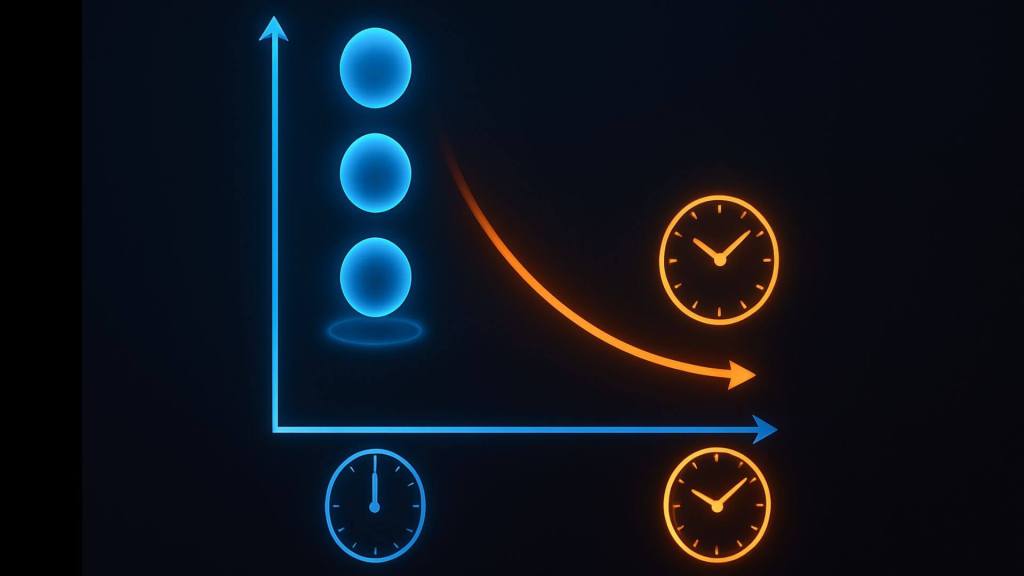

En física cuántica, medir no es inocuo. Cada medición implica una perturbación. Y cuanto más rápido se hace, menor suele ser la información recogida. Esto genera un dilema: si se quiere buena fidelidad, hay que esperar; pero si se necesita rapidez —como en la corrección de errores en un circuito cuántico—, se pierde precisión.

Los autores del estudio lo explican con claridad: “En la práctica hay una compensación entre la duración de la medición y su calidad”. Y añaden que esto impone un “límite inferior sobre cuán rápida puede ser una medición para lograr una fidelidad dada”.

Esta situación es particularmente problemática en tareas como las mediciones intermedias (midcircuit measurements), necesarias para detectar y corregir errores mientras se ejecuta una operación cuántica. Allí, cada milisegundo cuenta.

La idea clave: cambiar tiempo por espacio

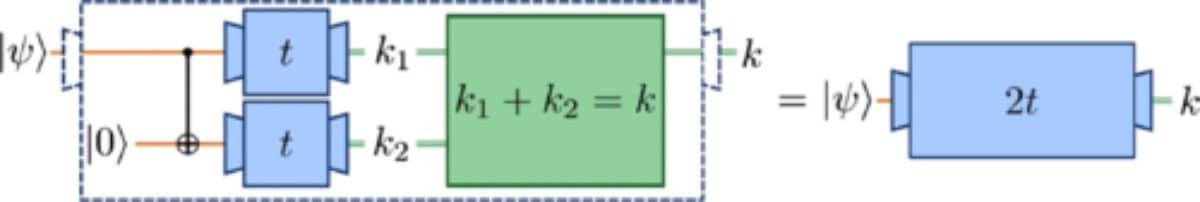

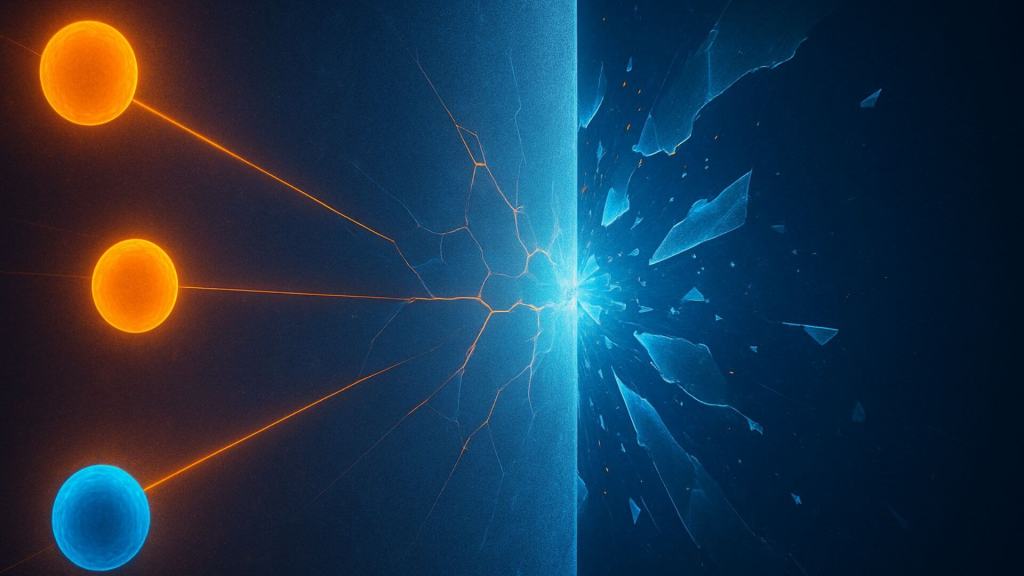

La propuesta del equipo consiste en entrelazar el cúbit que se desea medir con otros cúbits auxiliares —es decir, cúbits adicionales que no contienen información útil por sí mismos, pero que permiten mejorar la medición. Así, en lugar de esperar más tiempo para recopilar datos, se distribuye la tarea entre más cúbits y se mide en paralelo.

En el caso ideal, si se usan dos cúbits en lugar de uno, la misma calidad de medición se puede alcanzar en la mitad del tiempo. En palabras del artículo: “La estadística de la suma de emisiones de dos cúbits fluorescentes es equivalente a la de una medición de un solo cúbit durante el doble de tiempo”.

Este mecanismo se basa en una propiedad matemática bien conocida de la distribución de Poisson, que modela el número de fotones emitidos durante una medición. Al sumar los resultados de dos cúbits, se consigue la misma distribución estadística que la de un solo cúbit medido durante más tiempo, pero en menos tiempo.

¿Y si añadimos aún más cúbits?

El esquema no se limita a duplicar cúbits. Se puede escalar a tres, cuatro o más cúbits auxiliares, siempre que se mantenga el entrelazamiento correcto y se realicen las operaciones con fidelidad aceptable.

El artículo lo describe de forma precisa: “Podemos mantener la calidad de una medición constante, y acelerarla arbitrariamente, desde un tiempo t a un tiempo t/N, usando N mediciones en paralelo”.

Esto significa que, al menos en teoría, la medición se puede acelerar tanto como se desee, a cambio de disponer de suficientes cúbits auxiliares y de una arquitectura capaz de operarlos simultáneamente. En este enfoque, se sacrifica espacio físico (más cúbits) a cambio de velocidad, algo que puede ser muy ventajoso si el hardware lo permite.

Robustez frente a errores y decoherencia

Una cosa es que una idea funcione en papel, y otra que lo haga en un laboratorio. Por eso, los autores dedicaron buena parte del trabajo a probar la robustez del esquema frente a errores reales, como fallos en las compuertas CNOT —clave para entrelazar cúbits— y fenómenos de decoherencia durante la medición.

En sus simulaciones, incluso con tasas de error razonables, el sistema mantiene una mejora significativa en la velocidad de medición sin pérdida de precisión. Más aún: en ciertos rangos, la calidad de la medición mejora al usar más cúbits, gracias a la menor exposición a la decoherencia.

Según el estudio, “el esquema es robusto ante imperfecciones experimentales”, y bajo ciertas condiciones, puede lograr “una mejora superior a la lineal en la velocidad de medición”. Es decir, usar tres cúbits podría ser más del triple de rápido que usar uno solo.

El avance tiene implicaciones directas en uno de los grandes retos de la computación cuántica: la corrección de errores. Las mediciones intermedias —necesarias para detectar desviaciones— son especialmente sensibles al tiempo y a la fidelidad. Una técnica que permita acortarlas sin degradar el resultado es una ventaja estratégica.

Además, los autores destacan que su propuesta es “agnóstica respecto al hardware”, es decir, se puede aplicar a distintos tipos de plataformas cuánticas: cúbits atrapados por iones, cúbits de átomos neutros o superconductores. Esto amplía enormemente su aplicabilidad.

Otra posible aplicación está en la metrología cuántica, donde se requieren mediciones de alta precisión en sistemas extremadamente sensibles. Allí, cada segundo adicional implica más exposición al ruido. Reducir el tiempo sin perder calidad es un avance fundamental.

Por último, en futuras arquitecturas con gran número de cúbits, este enfoque podría convertirse en un estándar, integrándose como parte del diseño básico de los sistemas cuánticos.

Un avance conceptual con efectos prácticos

Aunque la idea de cambiar tiempo por espacio no es nueva en física, su aplicación concreta a la medición cuántica de forma tan directa y eficaz marca un punto de inflexión. La clave está en que el esquema no requiere nuevos tipos de dispositivos, sino una reconfiguración inteligente del uso de los cúbits disponibles.

La propuesta también pone en evidencia la madurez del campo: ya no se trata solo de probar que la computación cuántica es posible, sino de optimizar sus procesos internos con soluciones teóricas refinadas, pero realistas.

Este tipo de avances, discretos pero decisivos, son los que preparan el camino para que la computación cuántica salga del laboratorio y entre en el mundo real. Sin ruido, sin grandes titulares, pero con un impacto profundo en lo que está por venir.

Referencias

- Christopher Corlett, Ieva Čepaitė, Andrew J. Daley, Cica Gustiani, Gerard Pelegrí, Jonathan D. Pritchard, Noah Linden y Paul Skrzypczyk. Speeding Up Quantum Measurement Using Space-Time Trade-Off. Physical Review Letters 134, 080801 (2025). DOI: 10.1103/PhysRevLett.134.080801.

Cortesía de Muy Interesante

Dejanos un comentario: