La animación de movimientos humanos en entornos digitales ha sido un desafío constante. Desde las primeras películas CGI hasta los videojuegos modernos, capturar la forma en que interactuamos con objetos físicos ha requerido años de perfeccionamiento. Sin embargo, los resultados siguen estando limitados por los datos imperfectos de captura de movimiento y la falta de integración realista con la física del mundo real.

Aquí es donde entra en juego InterMimic, un sistema de inteligencia artificial diseñado para entrenar robots y simulaciones para imitar movimientos humanos con una precisión sin precedentes. Presentado en un reciente preprint académico, este enfoque combina aprendizaje automático, simulaciones físicas y un método innovador de enseñanza por distilación de políticas para corregir y mejorar la calidad de los datos de movimiento capturados.

El reto de imitar la interacción humano-objeto

La interacción humano-objeto (HOI, por sus siglas en inglés) es un problema complejo en el campo de la animación y la robótica. Tradicionalmente, se han utilizado datos de captura de movimiento (MoCap) para registrar cómo una persona manipula objetos, pero estos datos no siempre son perfectos. Errores de contacto, movimientos imprecisos y la falta de detalles en las manos pueden hacer que la simulación final se vea poco realista o físicamente incorrecta.

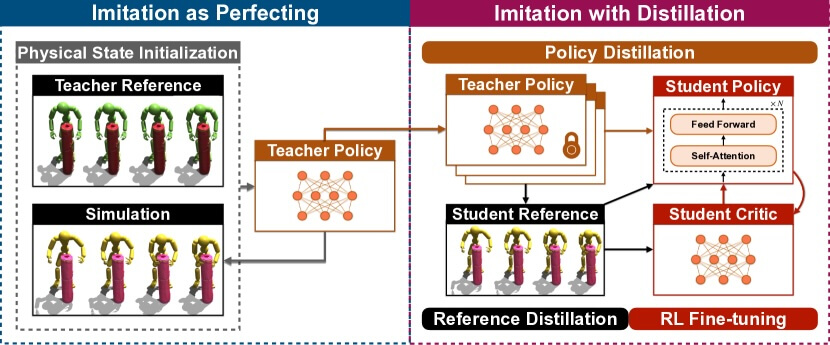

InterMimic aborda este problema con un enfoque en dos etapas. Primero, entrena políticas “maestras” en conjuntos de datos pequeños y específicos para corregir los errores en los movimientos capturados. Luego, estas políticas maestras se combinan en una política estudiante, que aprende de múltiples ejemplos refinados, logrando así una simulación más robusta y adaptable.

Cómo funciona InterMimic

El sistema introduce un método de aprendizaje basado en enseñanza progresiva. Se comienza con políticas maestras que “perfeccionan primero y luego escalan”. Es decir, primero aprenden a imitar con precisión movimientos simples y luego se les entrena en interacciones más complejas y variadas.

Para mejorar la fidelidad física de los movimientos, InterMimic emplea aprendizaje por refuerzo (RL, Reinforcement Learning) en la política estudiante. En lugar de limitarse a copiar los movimientos de los datos originales, la IA aprende a optimizarlos, asegurando que sean realistas y físicamente plausibles. Según los autores del paper, este proceso “permite a InterMimic superar la mera replicación de demostraciones y alcanzar soluciones de mayor calidad”.

Uno de los elementos clave de este modelo es la integración con generadores cinemáticos, lo que le permite predecir futuras interacciones basándose en movimientos anteriores. De este modo, InterMimic no solo reproduce el pasado, sino que también puede generar nuevas interacciones que sean coherentes con el contexto.

Corrección de errores y mejoras en la captura de movimiento

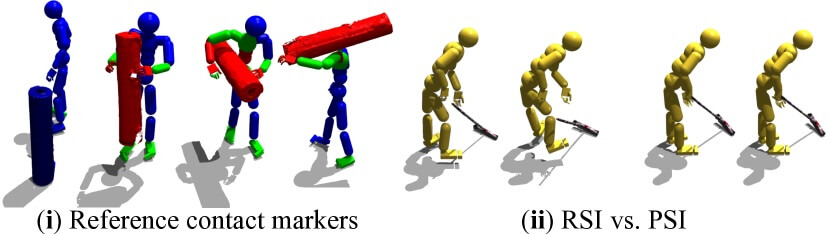

Uno de los problemas más comunes en los datos MoCap es la inconsistencia en los contactos entre la mano y los objetos. Muchas veces, las manos parecen flotar en el aire o atravesar superficies sin generar una respuesta física realista. Para solucionar esto, InterMimic implementa una estrategia llamada inicialización del estado físico (PSI, Physical State Initialization).

A diferencia de métodos tradicionales que comienzan cada simulación desde datos capturados, PSI selecciona estados iniciales basados en simulaciones previas exitosas. Esto reduce los errores de contacto y permite que el modelo corrija automáticamente los datos defectuosos, generando movimientos más creíbles.

Otro mecanismo clave es la terminación temprana de interacción (IET, Interaction Early Termination). Si una simulación detecta que un objeto se está comportando de forma irrealista (por ejemplo, si una caja atraviesa la mano en lugar de ser agarrada), la interacción se cancela y se reentrena el modelo para evitar estos errores en futuras simulaciones.

Aplicaciones en robótica y animación

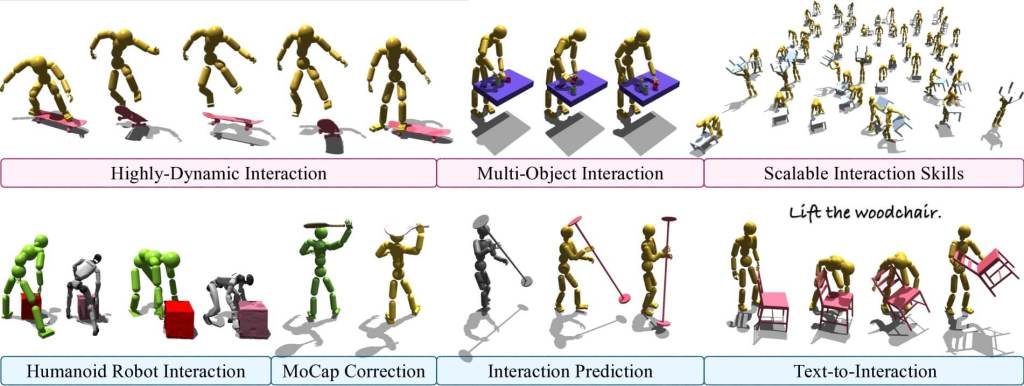

InterMimic no se limita solo a mejorar la animación de personajes digitales. Gracias a su capacidad de generalización, puede ser aplicado en robots humanoides que necesiten aprender a manipular objetos con movimientos más naturales. De hecho, el paper menciona que el sistema ha sido probado con el robot humanoide Unitree G1, logrando que realice tareas de manipulación de objetos sin necesidad de ajustes manuales.

En el campo de la animación digital, este modelo puede integrarse con motores de animación basados en inteligencia artificial para mejorar la calidad de las simulaciones. También puede utilizarse en la realidad virtual y los videojuegos, donde los personajes interactúan con su entorno de manera más realista, elevando la inmersión del usuario.

Otra aplicación interesante es la generación de interacciones a partir de texto. Esto significa que un usuario podría escribir una acción, como “levantar una silla”, y el sistema generaría automáticamente la animación correspondiente con una precisión física adecuada.

Comparación con otros modelos de simulación

Existen otros enfoques para la simulación de interacciones humano-objeto, como PhysHOI o SkillMimic, pero InterMimic presenta varias ventajas:

- Corrección de errores en MoCap: mientras que otros modelos imitan los datos tal cual, InterMimic los perfecciona antes de aprender de ellos.

- Escalabilidad: puede entrenarse en grandes volúmenes de datos sin perder precisión.

- Generalización sin ajuste manual: puede adaptarse a nuevos objetos y escenarios sin modificaciones específicas.

Según el paper, “nuestro enfoque permite la generación de interacciones versátiles y físicamente plausibles con una generalización sin precedentes”.

Limitaciones y futuras mejoras

A pesar de sus avances, InterMimic aún tiene desafíos por superar. Su sistema de interacción con las manos, por ejemplo, todavía no es completamente preciso para tareas de alta destreza. En escenarios donde se requiere un control fino de los dedos, como tocar un instrumento musical, podrían ser necesarias mejoras adicionales.

Por otra parte, aunque el modelo ha demostrado una capacidad impresionante de generalización, sigue habiendo casos en los que los movimientos generados no son completamente realistas. Resolver estos problemas requerirá entrenar el modelo con conjuntos de datos aún más diversos y detallados.

Referencias

- Sirui Xu, Hung Yu Ling, Yu-Xiong Wang, Liang-Yan Gui. InterMimic: Towards Universal Whole-Body Control for Physics-Based Human-Object Interactions. Preprint en arXiv (2025). DOI: https://sirui-xu.github.io/InterMimic.

Cortesía de Muy Interesante

Dejanos un comentario: