Cuando un grupo de científicos decidió plantearle a ChatGPT un antiguo problema matemático que aparece en los diálogos de Platón, no imaginaban que la respuesta del modelo los llevaría a cuestionarse si una inteligencia artificial puede realmente “razonar” o si simplemente repite lo aprendido. Lo que parecía un experimento académico más terminó abriendo una reflexión mucho más amplia: ¿es posible que una IA aprenda como un ser humano? ¿Puede equivocarse como lo haría un alumno en el aula?

El estudio, publicado en la revista International Journal of Mathematical Education in Science and Technology, relata una conversación cuidadosamente diseñada entre ChatGPT y un investigador, con el objetivo de examinar cómo el modelo responde a un problema geométrico clásico: duplicar el área de un cuadrado. Esta tarea no solo desafía el conocimiento matemático del sistema, sino que también pone a prueba la forma en que “construye” sus respuestas. Y lo más interesante no fue si acertó o falló, sino cómo lo hizo.

El viejo problema de Sócrates

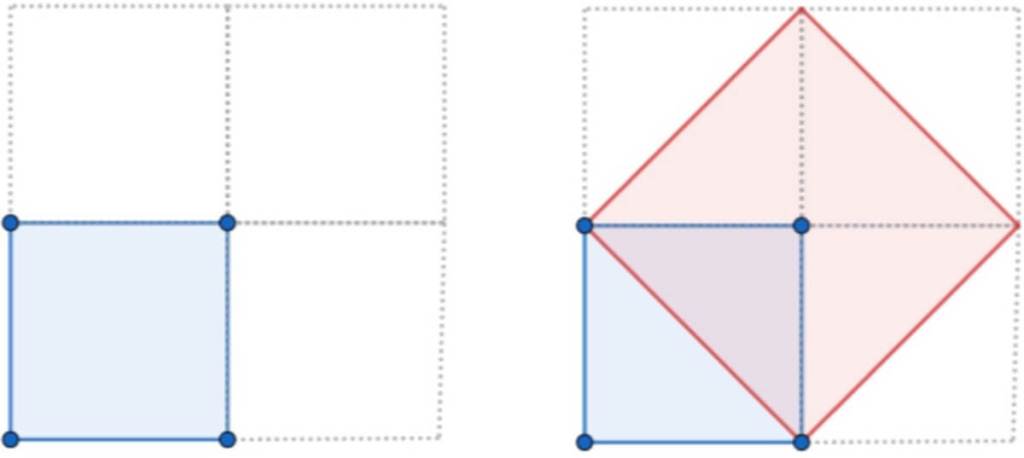

El desafío matemático que utilizaron los investigadores tiene raíces filosóficas profundas. Aparece en el diálogo Menón de Platón, donde Sócrates guía a un esclavo sin formación previa para que descubra por sí mismo cómo duplicar el área de un cuadrado. El niño comienza proponiendo que bastaría con duplicar la longitud de los lados, lo que en realidad cuadruplica el área. Tras varios errores y preguntas orientadas, el joven llega a comprender que la solución está en usar la diagonal del cuadrado original como lado del nuevo.

Este experimento es central en la teoría socrática de la reminiscencia, que sostiene que el conocimiento está latente en nosotros y se activa a través del diálogo. En el contexto moderno, los investigadores Nadav Marco (Universidad Hebrea de Jerusalén) y Andreas J. Stylianides (Universidad de Cambridge) se preguntaron si un modelo de lenguaje como ChatGPT, entrenado con millones de textos, podría enfrentarse a este mismo problema y resolverlo correctamente sin haber visto antes una solución explícita.

“El experimento de Platón revolucionó la educación occidental al afirmar que todos, incluso un esclavo, podían recuperar verdades eternas a través de la reminiscencia”, escriben los autores en el artículo. La pregunta que plantea su estudio es si una inteligencia artificial también puede activar “conocimientos” latentes cuando se le guía con las preguntas adecuadas.

ChatGPT ante el problema: ¿memoria o invención?

Cuando se le planteó a ChatGPT el problema de duplicar el área de un cuadrado de 2 unidades de lado, el modelo no cometió el mismo error inicial que el niño de Menón. En lugar de proponer duplicar los lados, dio una respuesta algebraica correcta, aunque no hizo referencia alguna a la solución geométrica clásica de Platón.

“Sorprendentemente, el Chat no mostró un reconocimiento explícito del problema de la ‘duplicación del cuadrado’ de Platón, a pesar de su prominencia histórica”, señalan los autores. Esto llevó a los investigadores a pensar que el modelo no estaba simplemente repitiendo algo memorizado, sino que estaba generando una solución por su cuenta.

Esta forma de razonar, basada en el álgebra y no en la geometría, refuerza la idea de que ChatGPT no actúa como un archivo de respuestas, sino que puede producir enfoques nuevos ante problemas conocidos. Sin embargo, más adelante en la conversación, el modelo sí fue capaz de recordar y aplicar la solución geométrica si se le daba el estímulo adecuado. Eso muestra un comportamiento híbrido: en ocasiones “recuerda”, y en otras “crea”.

Los errores que enseñan

En la segunda parte del experimento, los científicos complicaron el reto: le pidieron a ChatGPT que aplicara la misma lógica para duplicar el área de un rectángulo manteniendo sus proporciones. El modelo falló. Aseguró que no había una solución geométrica viable y sugirió que el uso del álgebra era la única vía. Pero los investigadores sabían que sí existía un método visual, y decidieron ofrecérselo como pista.

Lo interesante no fue solo que el modelo se equivocara, sino que esa equivocación reveló algo más profundo: el intento del modelo por aplicar una regla previamente útil (usar la diagonal) a una nueva situación, aunque inapropiadamente. Esto fue interpretado como una señal de razonamiento activo, más que de simple recuperación de datos. Tal como señalan los autores: “Parece que el Chat usó una especie de ‘gramática matemática universal’ para generar esta idea”, lo que recuerda a los errores por sobreaplicación que cometen los niños al aprender gramática.

Más aún, cuando se le presentó un nuevo problema con una construcción visual específica, el modelo fue capaz de entender la estrategia y aplicarla correctamente a un caso similar, lo que sugiere una cierta capacidad de aprendizaje por transferencia.

El concepto de “zona de desarrollo próximo” para una IA

Uno de los aportes más originales del artículo es la introducción del concepto de zona de desarrollo próximo (ZDP), tomado de la psicología educativa de Vygotsky, al análisis de la interacción con una IA. Esta zona se refiere al espacio entre lo que un alumno puede hacer por sí solo y lo que puede lograr con ayuda.

Los investigadores afirman que ChatGPT también parece tener su propia ZDP: problemas que no puede resolver sin apoyo, pero que sí logra abordar con la orientación adecuada del usuario. Esto no implica que la IA aprenda como un ser humano, pero sí sugiere que la interacción con el usuario puede activar soluciones que, de otro modo, no se producirían.

Como resumen, “nuestros lineamientos permitieron ubicar lo que podemos llamar la ‘ZDP del Chat’: problemas que el Chat no puede resolver por sí mismo, pero que puede resolver con cierta ayuda del usuario”, escriben los autores.

Este hallazgo tiene importantes implicaciones pedagógicas. Indica que el diseño de los prompts —las preguntas o instrucciones dadas a la IA— puede influir decisivamente en la calidad y profundidad de las respuestas. También subraya la necesidad de que estudiantes y profesores adquieran habilidades para interpretar, corregir y guiar a estas herramientas.

Lo que queda por explorar

El estudio concluye con una advertencia: no deberíamos sobreinterpretar el comportamiento de los modelos como si pensaran igual que los humanos. Aunque ChatGPT puede generar respuestas que imitan el razonamiento, no posee experiencia consciente ni comprensión conceptual.

Aun así, el potencial educativo es evidente. El uso de modelos como ChatGPT en entornos de enseñanza matemática podría abrir nuevas vías para el aprendizaje guiado, siempre que se enseñe también a detectar errores y evaluar la validez de las respuestas. Como destacan los autores, “la validación de pruebas generadas por IA se perfila como una competencia clave que debe integrarse en el currículo matemático”.

Finalmente, los investigadores proponen un enfoque equilibrado: ni idealizar ni descartar la capacidad de las IAs. Reconocer que sus respuestas pueden ser tanto fruto de recuerdos como de procesos generativos ayuda a utilizarlas con mayor inteligencia y precaución.

Referencias

- Nadav Marco & Andreas J. Stylianides (17 Sep 2025): An exploration into the nature of ChatGPT’s mathematical knowledge, International Journal of Mathematical Education in Science and Technology, DOI: https://doi.org/10.1080/0020739X.2025.2543817.

Cortesía de Muy Interesante

Dejanos un comentario: